Mit dem Aufkommen generativer KI und großer Sprachmodelle (Large Language Models, LLMs) verändert sich die Rolle von ERP-Systemen grundlegend. Statt nur Transaktionen zu buchen, Daten zu speichern und Berichte zu liefern, entwickeln sie sich zu interaktiven, lernenden Systemen. Dadurch unterstützen sie menschliche Entscheidungen, beschleunigen Abläufe und können Teile davon sogar ersetzen.

Außerdem markiert die Integration solcher Technologien in klassische ERP-Landschaften einen echten Wendepunkt. Entscheidend ist jedoch, dass dieser Wandel strategisch erfolgt und nicht opportunistisch oder rein experimentell. LLMs wie GPT oder Claude treten dabei als „Copilots“ auf, die vorhandene Systeme ergänzen, statt sie zu verdrängen.

Vom Transaktionssystem zum interaktiven Partner

Regelbasierte ERP-Systeme vs. lernfähige Sprachmodelle

Traditionelle ERP-Systeme sind regelbasiert und weitgehend deterministisch. Sie führen das aus, was ihnen explizit vorgegeben wird – nicht mehr und nicht weniger. Deshalb funktionieren sie stabil, allerdings reagieren sie nur innerhalb klar definierter Grenzen.

Generative KI agiert dagegen kontextbezogen, probabilistisch und lernfähig. Sie interpretiert Eingaben im Zusammenhang, erkennt Muster und erzeugt Inhalte, die über klassische Wenn-Dann-Logiken hinausgehen. Dadurch eröffnen sich neue Formen der Interaktion mit dem ERP, die über Masken, Transaktionen und statische Reports hinausreichen.

Zentrale Einsatzfelder generativer KI im ERP-Kontext

Aus dieser anderen Funktionsweise entstehen im ERP-Umfeld neue Anwendungsfelder:

- automatisierte Textgenerierung, etwa für Angebote oder Produktbeschreibungen

- intelligente Benutzerführung direkt im System

- Prozessanalyse und Mustererkennung in Abläufen und Daten

- Assistenz bei Anforderungs- und Codeerstellung

- Echtzeitunterstützung bei operativen und fachlichen Entscheidungen

Zudem lassen sich diese Funktionen in bestehende Strukturen integrieren, ohne das Kernsystem zu ersetzen. LLMs begleiten Nutzer und Entwickler somit wie ein Copilot entlang zentraler ERP-Prozesse.

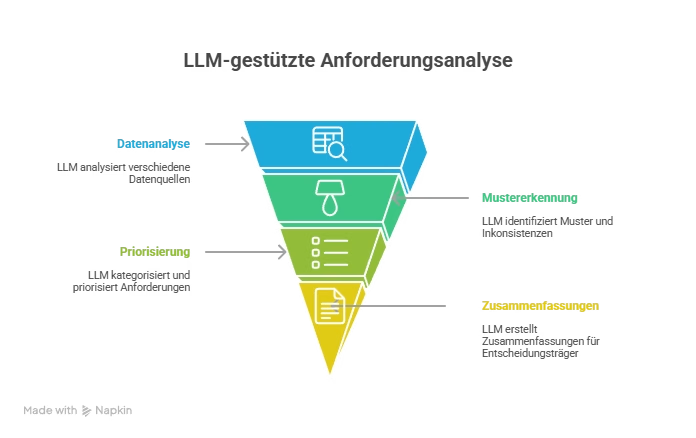

Anforderungsanalyse mit LLMs automatisieren

In klassischen ERP-Projekten verschlingt die Anforderungsanalyse viel Zeit und Ressourcen. Interviews, Workshops, Protokolle, Dokumentation und Abstimmungen erfolgen meist manuell. Dadurch entsteht oft ein Bruch zwischen Fachbereichssprache und technischer Umsetzung.

Ein LLM kann diese Phase deutlich beschleunigen und zugleich strukturieren. Es analysiert Gesprächsprotokolle, Systemdaten und Fachbereichsdokumente in großer Breite. Außerdem erkennt es Muster, doppelte Anforderungen und Inkonsistenzen, die in der manuellen Sicht leicht untergehen.

Darüber hinaus kategorisiert und priorisiert ein LLM Anforderungen automatisch nach vordefinierten Kriterien. Es erstellt Zusammenfassungen für Entscheidungsträger, die schnell einen Überblick über Konflikte, Abhängigkeiten und Lücken erhalten. Das Ergebnis ist eine Zeitersparnis von rund 30–60 % in der Analysephase – ohne Verlust an Detailtiefe.

Somit bleibt mehr Zeit für die fachliche Bewertung und die bewusste Gestaltung von Prozessen, während Routinearbeit der Strukturierung auf die KI verlagert wird.

Legacy-Code verstehen und neuen Code generieren

Große ERP-Systeme wie SAP enthalten oft zehntausende Zeilen ABAP-Code. Dieser ist historisch gewachsen, mehrfach erweitert und vielfach unzureichend dokumentiert. Dadurch entstehen regelrechte „Codewüsten“, deren Verständnis selbst für erfahrene Entwickler anspruchsvoll ist.

Generative KI hilft, diese Landschaften zu strukturieren und zu entschlüsseln. Sie analysiert bestehende Customizing-Objekte und Quellcodes. Außerdem kann sie veraltete Logiken kommentieren und Refactoring-Vorschläge machen. Dadurch wird sichtbar, was Codeabschnitte fachlich leisten und wo Redundanzen liegen.

Zugleich unterstützt ein LLM bei der Erstellung von Unit-Tests, indem es auf Basis vorhandener Funktionen sinnvolle Testfälle vorschlägt. Auf Grundlage von Funktionsbeschreibungen generiert es neuen Code, den Entwickler anschließend prüfen und anpassen.

LLMs agieren hier ausdrücklich als technische Co-Entwickler. Sie produzieren nicht blind Code, sondern unterstützen menschliche Entwickler durch Vorschläge, Erklärungen und Mustererkennung. Folglich sinken Entwicklungszeiten um bis zu 40 %, während Wissen über das System besser dokumentiert vorliegt.

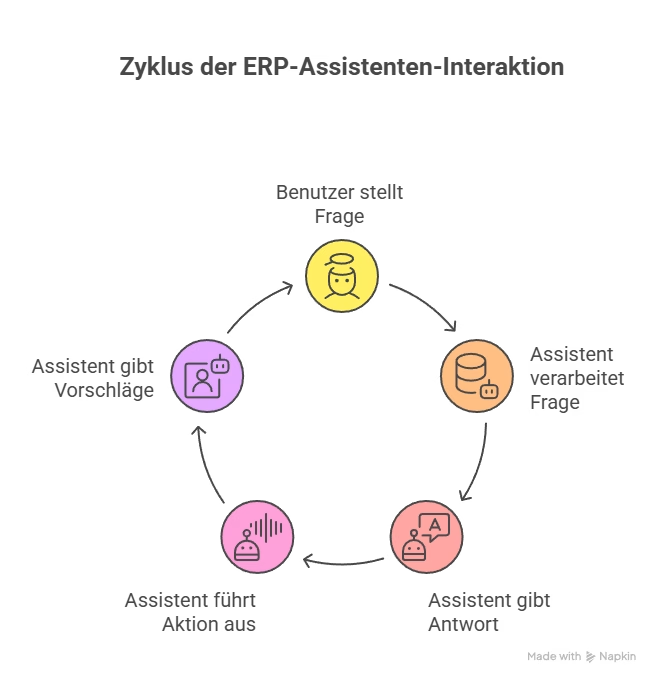

Intelligente Benutzerführung durch KI-gestützte Assistenten

Ein digitaler ERP-Assistent auf Basis eines LLM – etwa in Form eines Chatbots – kann direkt mit Nutzern interagieren. Statt Menüpfade zu suchen oder Handbücher zu lesen, formulieren Anwender ihre Anliegen in natürlicher Sprache.

Der Assistent beantwortet kontextsensitive Fragen und greift dabei auf ERP-Daten und Prozesslogiken zu. Außerdem kann er einfache Aktionen direkt ausführen, zum Beispiel: „Zeige alle offenen Rechnungen von Kunde X“. Dadurch reduziert sich der Navigationsaufwand im System deutlich.

Darüber hinaus macht der Assistent Vorschläge auf Basis vergangener Nutzungsmuster. Er begleitet Nutzer durch Prozesse, ohne dass ein hoher Schulungsaufwand nötig ist. Besonders für Gelegenheitsnutzer, die selten im ERP arbeiten, entsteht so ein spürbarer Nutzen: Sie erhalten schnell die benötigten Informationen, ohne die Systemtiefe im Detail zu kennen.

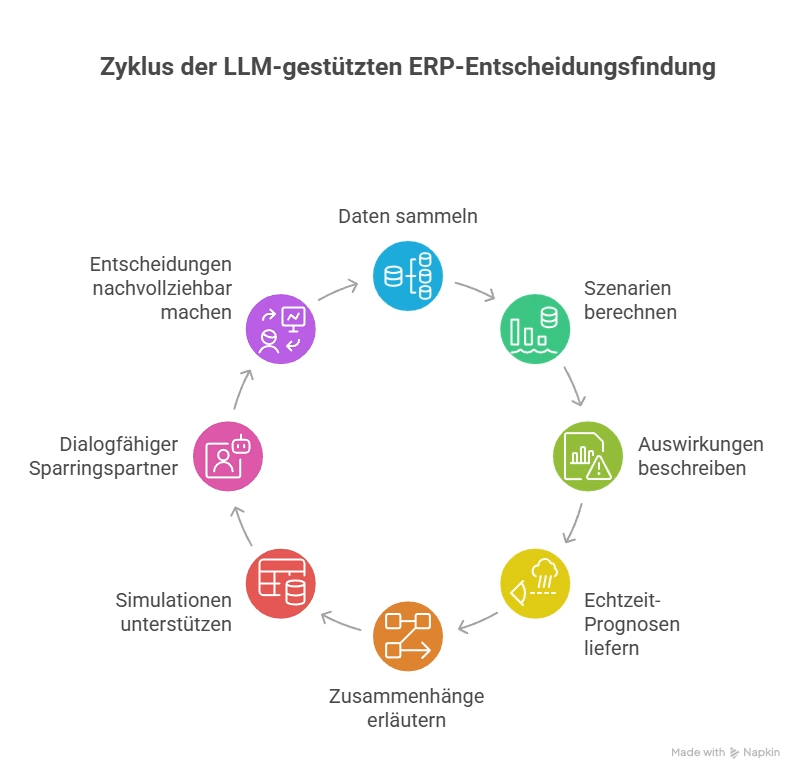

Vorhersage, Szenarienanalyse und Entscheidungsunterstützung

LLMs lassen sich mit klassischen KI-Technologien kombinieren, um Entscheidungen im ERP-Umfeld zu unterstützen. Während traditionelle Modelle Zahlen prognostizieren, bringt das LLM eine dialogfähige Oberfläche und Kontextverständnis ein.

So werden What-if-Analysen möglich, die sich in natürlicher Sprache formulieren lassen: „Wie verändert sich mein Lagerbestand bei 10 % Nachfrageanstieg?“ Das System greift auf aktuelle Daten zu, berechnet Szenarien und beschreibt die Auswirkungen.

Außerdem sind Echtzeit-Prognosen zu Absatzentwicklung, Liquiditätsplanung oder Lieferzeiten eingebunden. Die KI liefert nicht nur Zahlen, sondern erläutert Zusammenhänge. Zugleich unterstützt sie Simulationen von Planungsszenarien auf Basis aktueller Datenmodelle.

Dadurch agiert die KI nicht mehr als statische Auswertung, sondern als dialogfähiger Sparringspartner. Sie versteht Kontext, stellt Rückfragen und bietet proaktiv Alternativen an. Entscheidungen werden damit nachvollziehbarer, weil der Weg zur Empfehlung transparent bleibt.

Voraussetzungen für den erfolgreichen Einsatz generativer KI im ERP

Trotz des Potenzials müssen einige Voraussetzungen erfüllt sein, damit generative KI im ERP-Umfeld sicher und wirksam eingesetzt werden kann.

Zunächst benötigen LLMs strukturierten und kontrollierten Datenzugriff. Sie arbeiten nur so gut, wie Prozessdaten, Produktstammdaten oder Interaktionslogs gepflegt und zugänglich sind. Außerdem sind klare Sicherheits- und Berechtigungskonzepte erforderlich. Sensible ERP-Daten dürfen nicht unkontrolliert verarbeitet werden, deshalb braucht es rollenbasierte Zugriffskonzepte und technische Leitplanken.

Gerade im Finanzbereich ist Transparenz entscheidend. Deshalb muss nachvollziehbar sein, wie Vorschläge der KI zustande kommen und auf welche Daten sie sich stützt. Nur dann lassen sich Entscheidungen auditierbar dokumentieren.

Zugleich bleibt der Mensch im Sinne eines Human-in-the-Loop-Ansatzes im Prozess. LLMs sollen Empfehlungen geben, doch Entscheidungen müssen validierbar und korrigierbar bleiben. Dadurch entsteht ein Zusammenspiel aus Automatisierung und bewusster Kontrolle.

ERP + LLM: Synergie statt Systemersatz

Es geht nicht darum, ERP-Systeme durch LLMs zu ersetzen. Vielmehr sollen ihre Grenzen erweitert werden. Klassische Systeme sind strukturiert, exakt und regeltreu. LLMs ergänzen diese Stärken durch Flexibilität, Sprachverständnis und Kontextintelligenz.

In der Kombination entsteht ein hybrides System:

- das ERP sorgt für transaktionale Präzision

- das LLM liefert interaktive Intelligenz

Der Mehrwert entsteht in der Schnittmenge. Dies zeigt sich zum Beispiel in der Interaktion mit Nutzern, in der Analyse unstrukturierter Daten oder in der automatisierten Ableitung von Handlungsempfehlungen aus bestehenden Informationen. Dadurch bleibt das ERP das stabile Rückgrat der Unternehmensprozesse, während das LLM die Brücke zwischen Mensch, Daten und Entscheidung bildet.

Ausblick: Generative KI als Erweiterung des digitalen Arbeitsplatzes

ERP-Systeme müssen künftig mehr leisten als buchen, speichern und melden. Sie sollen aktiv Vorschläge machen, Aufgaben übernehmen und sich an den Nutzer anpassen. Generative KI und LLMs bilden den Schlüssel zu dieser Erweiterung des digitalen Arbeitsplatzes.

Allerdings hängt der Erfolg davon ab, wie kontrolliert, zielgerichtet und governance-konform diese Technologien eingesetzt werden. Wer Datenmanagement, Sicherheit und Transparenz ernst nimmt, kann LLMs so in ERP-Landschaften integrieren, dass aus reinen Transaktionsmaschinen echte interaktive Partner im Tagesgeschäft werden.

Generative KI im ERP: Wie LLMs die Rolle von ERP-Systemen verändern

Mit APIs und Microservices die ERP-Zukunft vorbereiten

Datenqualität & KI : KI kann nur so gut sein wie Ihre Daten

KI-ERP-Transformation Grundlagen und KI-Governance

KI im Unternehmen: 4 Mythen über die DSGVO