Unternehmen investieren heute massiv in KI-Technologien, intelligente Automatisierung und moderne ERP-Architekturen. Trotzdem scheitern viele Modernisierungsprojekte schon in frühen Phasen, weil die Qualität der zugrunde liegenden Daten nicht ausreicht. Monolithische ERP-Systeme haben über Jahre hinweg Daten gesammelt, erweitert und verändert – häufig ohne klare Regeln und ohne Governance. Dadurch entstehen Inkonsistenzen, Dubletten und Lücken, die jede Form von KI-gestützter Entscheidungsunterstützung ausbremsen. Deshalb bildet eine systematisch aufgebaute Datenqualität das Fundament für den gesamten Modernisierungsprozess.

Warum schlechte Daten jede KI ausbremst

KI-Modelle erkennen Muster, erstellen Prognosen und liefern Optimierungsvorschläge. Sie arbeiten jedoch ausschließlich mit den Daten, die sie vorfinden. Wenn diese Daten unvollständig, widersprüchlich oder veraltet sind, produziert die KI Ergebnisse, die bestenfalls nutzlos und schlimmstenfalls geschäftsschädigend sind. Gerade mittelständische Unternehmen erleben das sehr direkt bei Absatzprognosen, Stammdatenprozessen oder automatisierten Workflows.

Ein einfaches Beispiel macht die Auswirkungen greifbar: Existieren im ERP-System mehrere Lieferanteneinträge mit unterschiedlichen Schreibweisen, Adressen oder Zahlungsbedingungen, dann sieht die KI kein einheitliches Gegenüber. Stattdessen erhält sie fragmentierte Informationen. In der Folge entstehen falsche Bestellvorschläge, ungenaue Liquiditätsberechnungen oder fehlerhafte Auswertungen. Die Ursachen liegen dabei nicht in der KI, sondern in der Datenbasis.

Deshalb reicht es nicht, nur neue KI-Tools einzuführen. Unternehmen müssen zuerst sicherstellen, dass die zugrunde liegenden Daten konsistent, aktuell und eindeutig sind. Sonst verstärkt KI lediglich bestehende Probleme, anstatt Mehrwert zu schaffen.

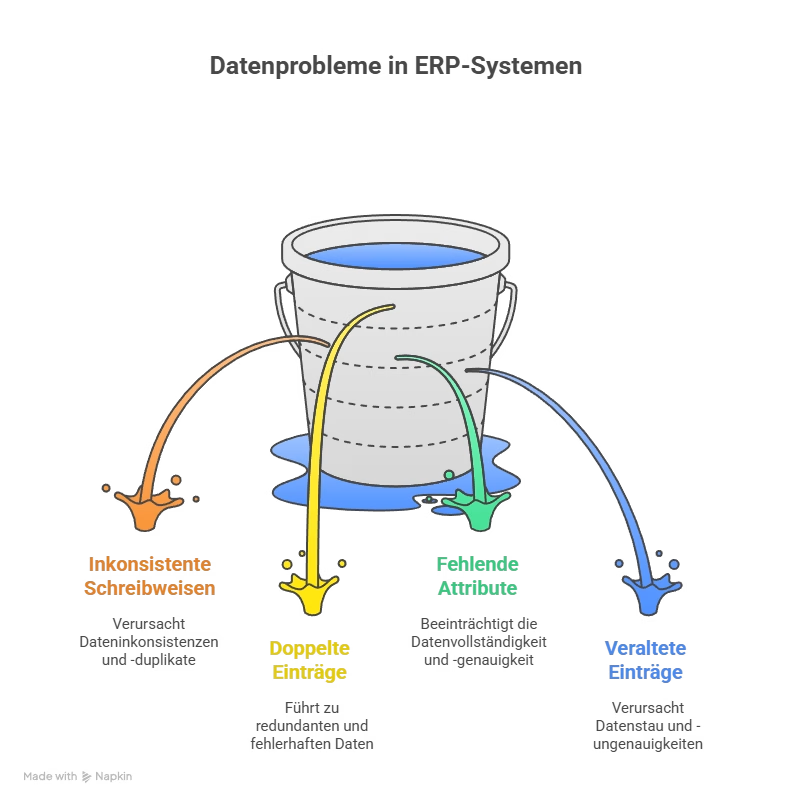

Datenprobleme in gewachsenen ERP-Landschaften

Die meisten Datenprobleme entstehen nicht auf einen Schlag, sondern schleichend. Unterschiedliche Vorsysteme, Importprozesse und manuelle Eingaben sorgen dafür, dass sich Stammdaten über die Jahre hinweg voneinander entfernen. Außerdem werden Regeln oft informell gelebt, aber selten verbindlich dokumentiert. Dadurch ist die Datenlage im Tagesgeschäft schwer einschätzbar.

Typische Effekte sind:

- Unterschiedliche Schreibweisen für denselben Geschäftspartner

- Dubletten bei Artikeln, Kunden oder Lieferanten

- Fehlende oder falsch gepflegte Attribute

- Veraltete Einträge, die nie bereinigt oder archiviert wurden

Diese Muster ziehen sich durch viele monolithische ERP-Installationen. Folglich werden Berichte ungenau, Workflows instabil und KI-Anwendungen unsicher. Deshalb ist eine systematische Bereinigung und Integration der Daten einer der ersten Hebel, um Verbesserungen zu erzielen.

Datenintegration und -bereinigung: Der erste Hebel für Verbesserungen

Datenintegration und -bereinigung setzen genau an dieser Stelle an. Sie schaffen aus gewachsenen, heterogenen Beständen eine konsistente Datenbasis. Moderne, KI-unterstützte Verfahren analysieren Strukturen, erkennen abweichende Schreibweisen und identifizieren Dubletten – oft zuverlässiger als manuelle Prüfungen. Dadurch lassen sich große Datenvolumina in überschaubarer Zeit konsolidieren.

Ein anschauliches Beispiel zeigt die Wirkung: Ein Unternehmen stand vor der Aufgabe, rund 800.000 Artikelbezeichnungen zu überarbeiten. Eine manuelle Bearbeitung hätte etwa sieben Jahre beansprucht. Mithilfe generativer KI ließ sich die Aufgabe um 95 Prozent beschleunigen. So entstand innerhalb von sechs Monaten eine konsistente Artikelstammbasis, die für weitere ERP-Modernisierungsschritte essenziell war.

Dieses Beispiel verdeutlicht, dass Datenbereinigung nicht nur ein technisches Thema ist. Sie hat direkte wirtschaftliche Auswirkungen, weil sie Projektdauer, Fehlerquote und Nutzbarkeit von KI-Anwendungen stark beeinflusst. Wer hier gezielt investiert, reduziert Aufwand in allen nachfolgenden Phasen – von Automatisierung über Analytics bis hin zu Predictive-Maintenance-Szenarien.

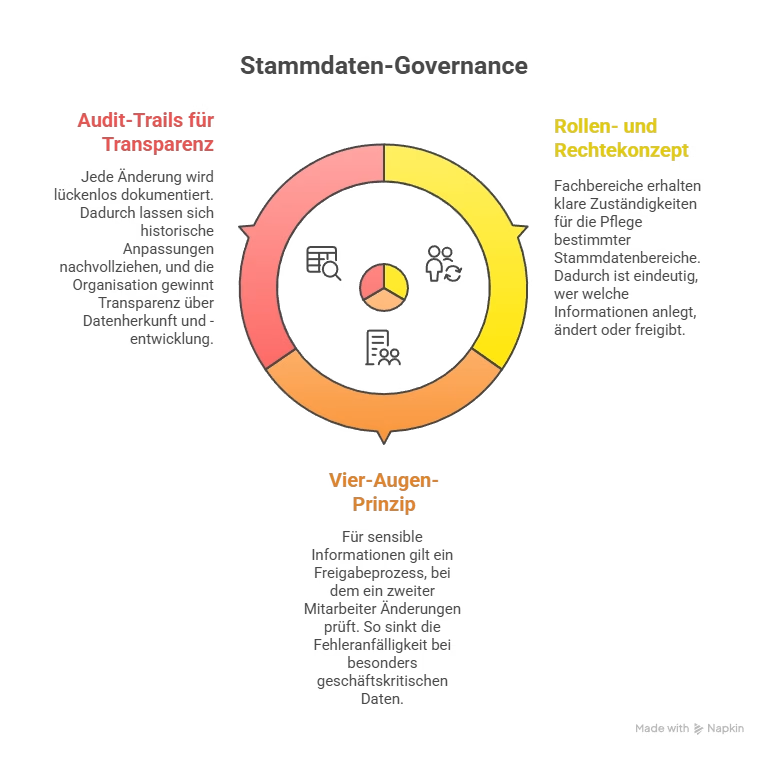

Stammdaten-Governance: Struktur statt Zufall

Eine einmalige Bereinigung reicht jedoch nicht aus. Gute Datenqualität entsteht nur dann dauerhaft, wenn klare Governance-Strukturen existieren. Stammdaten-Governance definiert Verantwortlichkeiten, Rechte und Prozesse, damit Daten langfristig konsistent bleiben. Unternehmen sollten dabei drei Grundprinzipien berücksichtigen:

- Rollen- und Rechtekonzept

Fachbereiche erhalten klare Zuständigkeiten für die Pflege bestimmter Stammdatenbereiche. Dadurch ist eindeutig, wer welche Informationen anlegt, ändert oder freigibt. - Vier-Augen-Prinzip für kritische Änderungen

Für sensible Informationen gilt ein Freigabeprozess, bei dem ein zweiter Mitarbeiter Änderungen prüft. So sinkt die Fehleranfälligkeit bei besonders geschäftskritischen Daten. - Audit-Trails für Transparenz

Jede Änderung wird lückenlos dokumentiert. Dadurch lassen sich historische Anpassungen nachvollziehen, und die Organisation gewinnt Transparenz über Datenherkunft und -entwicklung.

Diese Mechanismen verhindern, dass alte Gewohnheiten nach der Modernisierung wieder zu neuen Inkonsistenzen führen. Zudem sorgen sie dafür, dass das System stabil bleibt und neue KI- oder Automatisierungslösungen auf einer verlässlichen Datenbasis aufsetzen können.

Ein Vergleich aus der Praxis hilft beim Verständnis: Wenn ein Unternehmen jahrelang in eine Maschine investiert, aber die Wartung vernachlässigt, verschlechtert sich die Leistung trotz moderner Technologie. Genauso verhält es sich mit ERP-Daten – ohne Governance kehren alte Fehler automatisch zurück.

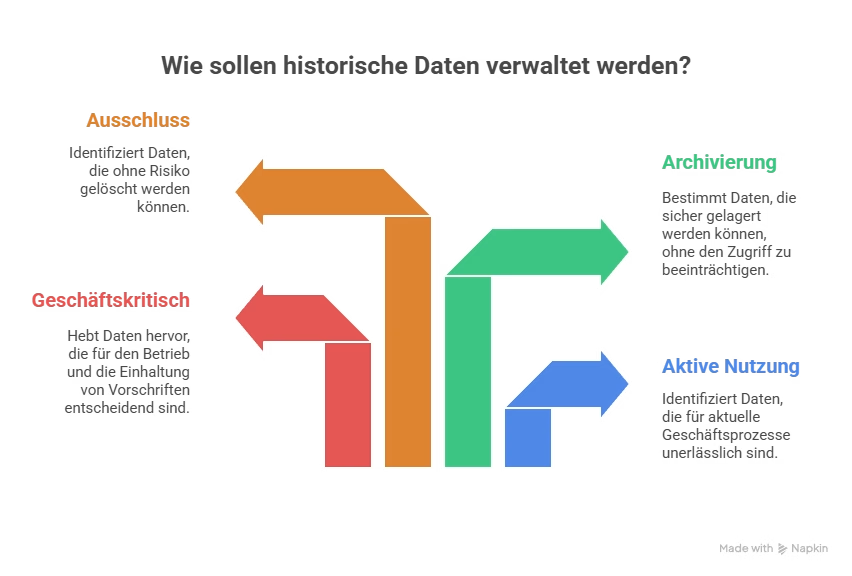

Bewertung historischer Daten: Was behalten, was ignorieren?

Ein weiterer kritischer Punkt ist der Umgang mit historischen Daten. Viele Unternehmen gehen davon aus, dass sie sämtliche historischen Daten in neue Systeme übernehmen müssen. Diese Annahme führt zu hohen Kosten, unnötigen Komplexitäten und längeren Projektdauern. Tatsächlich sind nur ausgewählte Datenbestände für KI oder ERP-relevante Prozesse wirklich wertvoll.

Deshalb sollten Unternehmen systematisch prüfen:

- Welche Daten werden aktuell aktiv genutzt?

- Welche Informationen sind geschäftskritisch oder regulatorisch vorgeschrieben?

- Welche Bestände können archiviert oder ausgeschlossen werden?

In der Praxis sind meist nur Stammdaten, offene Vorgänge und relevante Informationen der letzten drei bis sieben Jahre entscheidend. Ältere Daten lassen sich archivieren, ohne die Modernisierung zu beeinträchtigen. Dadurch entstehen schlankere Datenmigrationsprojekte, weniger Fehlerquellen und eine deutlich beschleunigte Einführung von KI-Anwendungen.

Warum Phase 2 eine zentrale Voraussetzung für KI-Erfolg ist

Datenqualität wirkt sich auf alle nachfolgenden Phasen der ERP-Modernisierung aus. Ohne eine robuste Datenbasis lassen sich weder APIs effektiv nutzen noch Automatisierungsprozesse stabil implementieren. Außerdem funktionieren LLM-basierte Assistenten, Vorhersagemodelle und Prozessanalysen nur dann zuverlässig, wenn die zugrunde liegenden Informationen korrekt und konsistent sind.

Phase 2 bietet daher einen doppelten Vorteil:

- Technisch: KI-Systeme arbeiten zuverlässiger und liefern belastbare Ergebnisse, weil sie auf einer bereinigten und strukturierten Datenbasis aufsetzen.

- Organisatorisch: Datenpflegeprozesse werden standardisiert und durch Governance abgesichert, wodurch langfristige Stabilität entsteht.

Unternehmen, die gezielt in diese Phase investieren, schaffen nicht nur ein technisches Fundament. Sie entwickeln Daten zu einer strategischen Ressource. Dadurch werden Informationen zu einem aktiven Werttreiber der ERP-Modernisierung, anstatt als Last oder Risiko wahrgenommen zu werden.

Generative KI im ERP: Wie LLMs die Rolle von ERP-Systemen verändern

Mit APIs und Microservices die ERP-Zukunft vorbereiten

Datenqualität & KI : KI kann nur so gut sein wie Ihre Daten

KI-ERP-Transformation Grundlagen und KI-Governance

KI im Unternehmen: 4 Mythen über die DSGVO